FifF im Einsatz für den Frieden

Die Welt ist vielfältig und komplex

Seit Juni 1984 gibt es den Verein Forum InformatikerInnen für Frieden und gesellschaftliche Verantwortung, kurz FIfF. Seine Mitglieder versuchen über die tiefgreifende Verflechtung von Informatik und Militär aufzuklären und sich für eine Abrüstung der Informatik in militärischen Anwendungen zu engagieren. Anlässlich dieses Jubiläums hat Constanze Kurz mit Hans-Jörg Kreowski und Rainer Rehak darüber gesprochen, welche Rolle die Informatik im Bereich des Militärs einnimmt.

Auf die vielen lesenswerten Aspekte dieses Gesprächs können wir nicht im einzelnen eingehen. Wir wollen uns auch anlässlich der aktuellen Ausgabe der Zeitschrift des FIfF auf die kritische Einordnung des aktuellen KI-Hypes konzentrieren und steigen konkret ein.

Rainer Rehak sagt im Interview: Nehmen wir einmal an, das KI-System entscheidet darüber, wer berechtigt ist,

- Sozialleistungen zu beziehen,

- welche Medikamente ein Mensch braucht oder auch

- welches militärisches Ziel angegriffen werden soll.

Systeme können immer nur kontextabhängige Antworten geben. Menschen und die ganze Welt sind aber viel zu komplex, als dass uns ein System etwas über sie erzählen könnte.

Und damit verweist er auf die Anlässe, die auch zur Gründung des FifF geführt haben. Vor 40 Jahren ging es um den NATO-Doppelbeschluss und die Aufstellung von rund 200 US-Atomsprengköpfen sowie mehreren hundert Marschflugkörpern in Deutschland. Wären sie zum Einsatz gekommen, wäre von Mitteleuropa und Deutschland nichts mehr übrig. Allein die Reduzierung der Vorwarnzeiten von 20-30 Minuten bei Interkontinentalraketen auf 5 Minuten für diese Mittelstreckenraketen wäre auch oder sogar gerade bei Computer-unterstützter Entscheidung ein ungeheures Risiko gewesen.

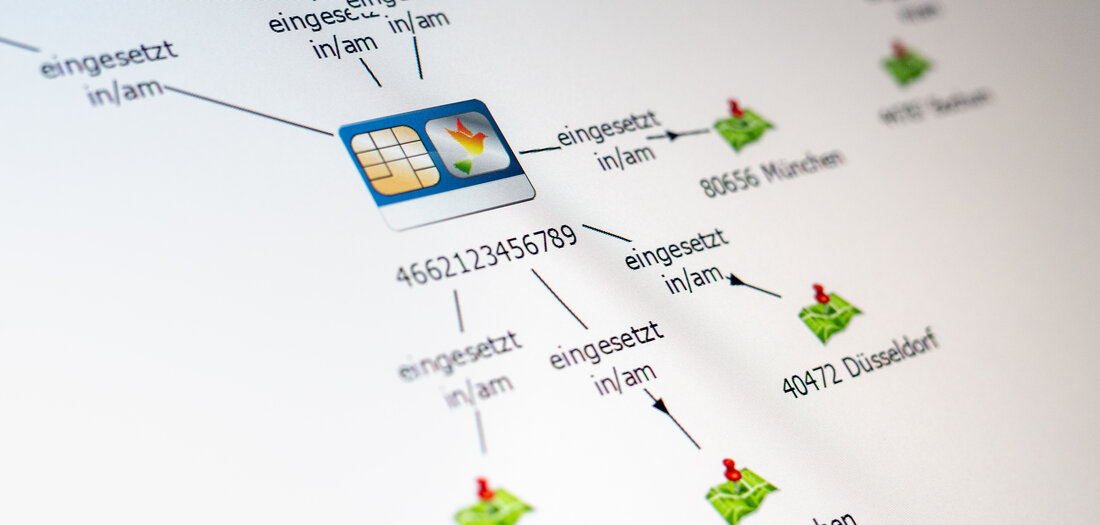

Prof. Hans-Jörg Kreowski weist dabei auf die unzuverlässig programmierten Frühwarnsysteme hin. Das Risiko dieser Systeme bestand darin, dass sie fälschlicherweise Bedrohungen meldeten und damit leicht zu falschen Entscheidungen hätten führen können.

Ein Beispiel dafür ist der Fall Stanislaw Petrow: Am 26. September 1983, während des Kalten Krieges, meldete das Frühwarnradar der Sowjetunion den Start einer Interkontinentalrakete mit vier weiteren Raketen von Stützpunkten in den Vereinigten Staaten aus. Stanislaw Petrow, ein Offizier der sowjetischen Luftverteidigungsstreitkräfte, der in der Kommandozentrale des Frühwarnsystems Dienst tat, hielt diese Warnungen für Fehlalarme - und rettete damit wahrscheinlich die Menschheit.

Unbemenschte Waffen

Inzwischen sind Computer nicht nur Anzeigeinstrumente, sondern führen die militärischen Waffen selbstständig. Neben den laufenden Drohnenkriegen (Armenien-Aserbaidschan und Russland-Ukraine) ist dafür ein Beispiel die Entwicklung des „Future Combat Air System“ (FCAS) von Frankreich (FCAS stoppen! ). Ein neues Kampfflugzeug soll entwickelt werden, das dann in Drohnenschwärmen in der ganzen Welt Lufthoheit für Deutschland und Frankreich erzeugen soll. Dafür wären auch allein für die Entwicklung wieder mehr als 100 Milliarden Euro nötig und damit fängt die Produktion ja erst an.

FCAS soll von einer KI-Plattform aus geplant, gesteuert, organisiert werden. Wir können erst einmal davon ausgehen, dass bis jetzt davon noch fast nichts funktioniert. Aber selbst wenn "etwas" davon läuft, dann gilt auch für dieses System das oben Gesagte und grundsätzlich die Regel, dass jede 1000-ste Programmzeile fehlerhaft ist. Welcher Mensch würde sein Leben einem solchen System anvertrauen oder gar das Überleben eines ganzen Landes.

KI als Müllerzeuger

Hinzu kommt eine Erfahrung, die man beim Spielen mit den gängigen KI-Werkzeugen gewinnt. Die KI sammelt (beliebige, auch fehlerhafte) Daten aus dem Internet und interpretiert diese. Die Ergebnisse werden deshalb fehlerhaft sein und gelangen im Laufe der Zeit wieder ins Internet. Das (menschliche) Wissen im Internet wird also mit der Zeit fehlerhafter und in der Summe schlechter. Wollen wir so etwas?

KI-Modelle, die auf fehlerbehafteten Datensätzen trainiert wurden, geben (auch) falsche Antworten. Garbage in, garbage out.

Mehr dazu bei https://netzpolitik.org/2024/40-jahre-fiff-gegen-die-unheilvolle-verflechtung-von-informatik-und-militaer-2/

Kategorie[21]: Unsere Themen in der Presse Short-Link dieser Seite: a-fsa.de/d/3AX

Link zu dieser Seite: https://www.aktion-freiheitstattangst.org/de/articles/8798-20240604-fiff-im-einsatz-fuer-den-frieden.html

Link im Tor-Netzwerk: http://a6pdp5vmmw4zm5tifrc3qo2pyz7mvnk4zzimpesnckvzinubzmioddad.onion/de/articles/8798-20240604-fiff-im-einsatz-fuer-den-frieden.html

Tags: #FifF #Jubiläum #Interview #Algorithmen #AI #KI #fehlerhaft #FalsePositives #NATO #Doppelbeschluss #FCAS #Drohnenkriege #Petrow