19.03.2023 KI und neuronale Netze

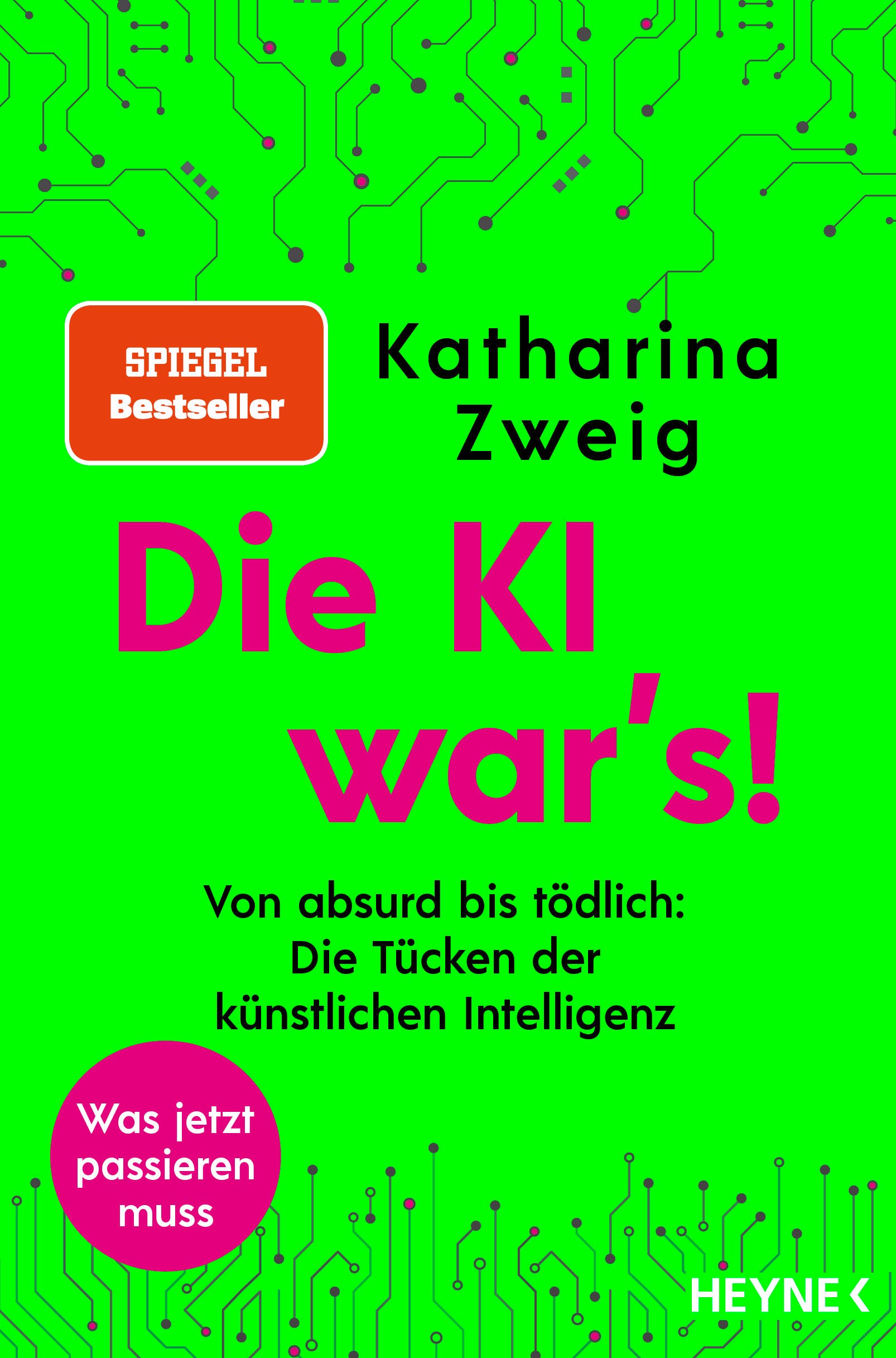

Wenn Computer sprechen und malen sollen

Der Erfolg bei der Erzeugung von künstlicher Intelligenz wäre das bedeutendste Ereignis in der Geschichte des Menschen. Unglücklicherweise könnte es auch das letzte sein. Stephen Hawking

Gestern hatten wir uns mit den Möglichkeiten und Risiken bei der Benutzung des KI-Programms ChatGPT auseinandergesetzt. Dabei haben wir uns auf die Texterkennung und -generierung fokussiert und dabei vergessen, dass ein wesentlicher Teil auch die Spracherkennung und -genererierung ist. Mit einem "Roboter" oder Programm in der uns gewohnten Sprache kommunizieren zu können ist natürlich viel angenehmer als eine Tastatur zu benutzen.

Deshalb wollen wir heute auf einen Artikel bei Spektrum.de verweisen und ergänzen, dass

- ChatGPT inzwischen auch Bilder erkennen und nach unseren Wünschen generieren kann,

- maschinelle Spracherkennung schon seit den 1950-iger Jahren ein Ziel der Programmierung ist.

Manon Bischoff schreibt auf Spektrum.de:

Im Januar 1954 war eine IBM-701-Maschine der erste für wissenschaftliche Zwecke entwickelte Rechner, er wog knapp zehn Tonnen und tat etwas Unvorstellbares: Mit russischen Beispielsätzen gefüttert, druckte er eine ins Englische übersetzte Version aus.

Es dauerte noch 60 Jahre bis zum Aufkommen neuronaler Netze in den 2010er und 2020er Jahren, um Algorithmen so leistungsfähig zu machen, dass sie Texte verlässlich von einer Sprache in eine andere übertragen können. Nun kann ChatGPT sogar Witze erfinden - auch wenn diese meist nicht gut sind. Witze sind jedenfalls schwieriger zu erfinden als ein ansprechendes Bild zu malen. Für das Malen reicht ein Verständnis (= eine Tabelle) zu Farben und Beispielbilder von allen möglichen Objekten.

Wie bei der Übersetzung und der Spracherkennung reicht es nicht, so eine Tabelle (= Datenbank) nach einem Stichwort zu durchsuchen, sondern die Verknüpfungen müssen nach der Aufgabenstellung verschieden sein. Dazu benötigt man neuronale Netze, die ChatGPT so erklärt:

Neuronale Netze sind eine Art von Algorithmus für maschinelles Lernen, der von der Struktur und Funktion des menschlichen Gehirns inspiriert ist. Sie bestehen aus miteinander verbundenen Knoten oder »Neuronen«, die Informationen verarbeiten und zwischen den Schichten des Netzes weiterleiten. Jedes Neuron empfängt Eingaben von anderen Neuronen, führt an diesen Eingaben eine einfache mathematische Operation durch und leitet das Ergebnis dann an andere Neuronen in der nächsten Schicht weiter. Auf diese Weise können neuronale Netze lernen, Muster in Daten zu erkennen und auf der Grundlage dieser Daten Vorhersagen zu treffen.

Auf Spektrum.de heißt es dazu: Im Gegensatz zu gewöhnlichen Algorithmen macht der Programmierer in neuronalen Netzen keine eindeutigen Vorgaben (etwa: falls Neuron 2 aus Schicht 3 ein Signal mit Wert 0,77 erhält, dann wandle es in 0,89 um). Stattdessen lässt man das Netz selbst "lernen", welche Einstellungen am geeignetsten sind, um eine Aufgabe zu bewältigen.

Da der Computer schnell ist, kann er seine anfänglichen Fehler mit der Zeit ausbügeln. Allerdings braucht er dazu auch korrekte Rückmeldungen. Bestätigt man ihn in seinen Fehlern, so - kommen wir auf den Artikel von gestern zurück und haben es nun mit einem Rassisten oder anderem Idioten zu tun ...

Welche weiteren Einschränkungen die Computer beim "Lernen" unterworfen sind, erklärt Manon Bischoff auf Spektrum.de sehr gut und beschreibt auch die Fortschritte in den ChatGPT Versionen der letzten Jahre. Der Aufbau der neuronalen Netze kann - auch wegen der immer noch mangelhaften Rechenleistung - nur auf kurze Distanzen (der Begriffe in der Matrix) verlässlich sein. Deshalb ist bei aller Arbeit, die nun ein Computer erledigen kann, wichtig zu bedenken, dass er dies nur kann, weil Menschen ihn vorher bei den Bewertungen der Zusammenhänge richtig trainiert haben. D.h. natürlich auch, dass er nur das gut kann, wozu er trainiert worden ist.

Mehr dazu bei https://www.spektrum.de/news/wie-funktionieren-sprachmodelle-wie-chatgpt/2115924#Echobox=1678347819

und der Artikel von gestern https://www.aktion-freiheitstattangst.org/de/articles/8339-20230318-was-bietet-chatgpt.htm

Kategorie[21]: Unsere Themen in der Presse Short-Link dieser Seite: a-fsa.de/d/3t4

Link zu dieser Seite: https://www.aktion-freiheitstattangst.org/de/articles/8340-20230319-ki-und-neuronale-netze-.htm

Link im Tor-Netzwerk: http://a6pdp5vmmw4zm5tifrc3qo2pyz7mvnk4zzimpesnckvzinubzmioddad.onion/de/articles/8340-20230319-ki-und-neuronale-netze-.htm

Tags: #Algorithmen #ChatGPT #Cyberwar #Wissen #lernfähig #Spracherkennung #malen #kreativ #neuronaleNetze #OpenSource #Menschenrechte #Copyright #KI #AI #KuenstlicheIntelligenz #Tay #Twitter #Microsoft #Tesla #Musk #Rassist #DataMining